Сьогодні вже не є новиною, що шахраї використовують штучний інтелект для клонування голосів знайомих жертв. Часто жертви отримують дзвінки від того, хто, на їхню думку, є рідним, директором або колегою, який повідомляє про термінову справу, що вимагає термінових дій, таких як переказ грошей, надання логінів та паролів або перехід на шкідливий веб-сайт.

Дослідники та державні службовці протягом кількох років попереджають про цю загрозу. У 2023 році Агентство з кібербезпеки та безпеки інфраструктури заявило, що загрози з боку дипфейків та інших форм синтетичних медіа зросли «в рази». У минулому році безпекова компанія Mandiant, що входить до складу Google, повідомила, що такі атаки виконуються з «вражаючою точністю, створюючи більш реалістичні фішингові схеми.

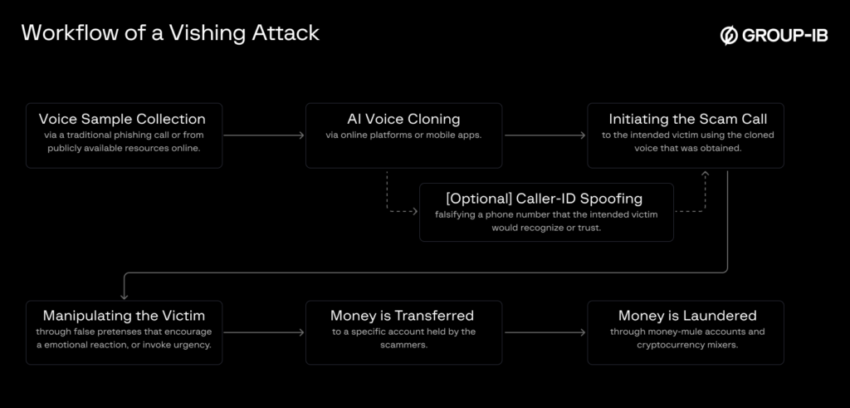

Структура шахрайського дзвінка з використанням дипфейків

У середу компанія Group-IB окреслила основні етапи проведення таких атак. Ключовим є те, що їх легко відтворити в масовому масштабі, і їх важко виявити чи зупинити.

Основні етапи виглядають так:

- Збирання зразків голосу особи, яка буде імітуватися. Часто достатньо зразків тривалістю в три секунди. Їх можна отримати з відео, онлайн-зустрічей або попередніх телефонних розмов.

- Введення зразків у системи синтезу мови на базі штучного інтелекту, такі як Tacotron 2 від Google, Vall-E від Microsoft або сервіси ElevenLabs та Resemble AI. Ці системи дозволяють зловмисникам використовувати інтерфейс «текст в мовлення», що відтворює певні слова голосом і манерами спілкування людини, яку імітують. Багато служб забороняють подібне використання дипфейків, однак, як показало дослідження, проведене в березні, заходи безпеки, що їх обмежують, можуть бути легко подолані.

- Додатковим кроком є підробка номера телефону особи або організації, яку імітують. Ці техніки використовуються вже десятиліттями.

- Потім зловмисники ініціюють шахрайський дзвінок. У деяких випадках клонований голос дотримується сценарію.

У складніших атаках фейкова мова генерується в реальному часі за допомогою програмного забезпечення для маскування або трансформації голосу. Атаки в реальному часі можуть бути більш переконливими, оскільки дозволяють зловмиснику відповідати на запитання, які може задати скептично налаштований співрозмовник.

«Хоча в реальному часі імітація була продемонстрована в проектах з відкритим кодом і комерційних API, використання дипфейків у прямому ефірі залишається обмеженим», — зазначила компанія Group-IB. «Однак, враховуючи постійний розвиток швидкості обробки та ефективності моделей, вживання в реальному часі очікується, що стане більш поширеним в найближчому майбутньому.»